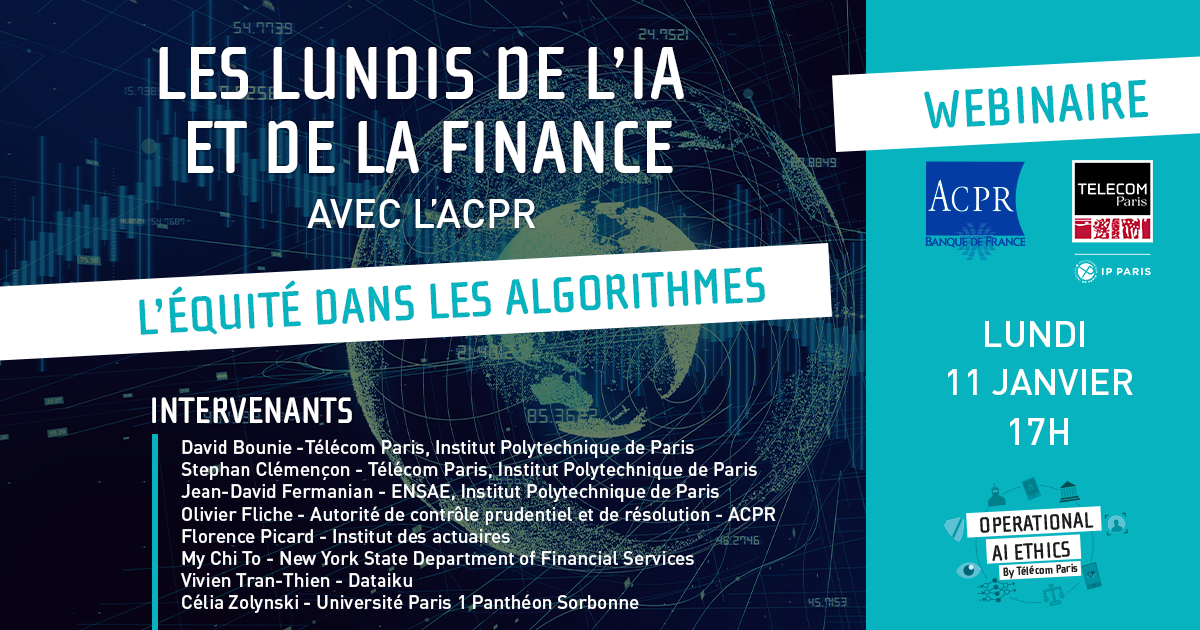

Regards interdisciplinaires sur les biais algorithmiques dans la finance

lundi 25 janvier 2021

Lors de son introduction, David Bounie, professeur d’économie à Télécom Paris a précisé que le sujet choisi pour cette conférence résonne à la fois avec les enjeux d’actualité et avec les intérêts de recherche de Télécom Paris.

Par la suite, Olivier Fliche, directeur du pôle Fintech-innovation de l’ACPR a souligné l’importance du sujet des biais pour un régulateur et particulièrement les biais statistiques qui peuvent avoir un impact sur la gestion des risques par les établissements financiers, mais aussi sur la protection de la clientèle, domaines où l’ACPR reste très vigilante.

Le simple fait de parler des biais soulève déjà des défis en matière de vocabulaire. Le terme anglais « fairness » signifie à la fois la loyauté et l’équité, bien que ces termes aient des sens différents en français. Le terme « biais », quant à lui, couvre différents phénomènes, allant des biais de sélection aux biais cognitifs.

Loin de pouvoir couvrir en détail tous les enjeux relatifs aux biais, ce webinaire se veut être un échange entre plusieurs acteurs, académiciens et industriels, sur la façon de gérer les biais introduits par les nouvelles technologies. L’étude des biais statistiques n’est pas nouvelle, mais quels changements induisent les algorithmes ?

Table ronde 1 : Biais algorithmique, équité et discrimination

En commencement de cette première table ronde, animée par David Bounie, Jean-David Fermanian, professeur de Finance et Statistique à l’ENSAE, Institut Polytechnique de Paris, a présenté le problème du point de vue mathématique. (Télécharger la présentation | Regarder la vidéo) Il a souligné la différence entre les concepts statistiques et les approches éthiques des biais. Le défi étant de s’assurer qu’un attribut protégé « S » n’affecte pas la probabilité d’une prédiction « Y ». On peut distinguer plusieurs définitions mathématiques de l’équité : la parité démographique, l’ « equalized odds » , l’« equal opportunity » et le « lack of disparate treatment ». Chaque approche reflétant un angle de vue différent par rapport au problème. Pour corriger les biais, il ne suffit pas, hélas, d’enlever l’attribut protégé « S », car les autres attributs du vecteur « X » peuvent conduire indirectement à l’attribut protégé. Le défi statistique est donc d’apporter des corrections aux biais sans détruire le pouvoir prédictif du modèle. Les mesures correctives sont de trois types :

- le « pre-processing », qui consiste à apporter des modifications aux données d’apprentissage, en éliminant certaines données, en modifiant les étiquettes, ou les pondérations ;

- la modification du modèle lui-même pendant la phase de calibration ;

- le « post-processing », qui consiste à modifier les sorties du modèle pour les rendre plus équitables.

Le professeur de mathématiques appliquées à Télécom Paris, Stéphan Clémençon a ensuite souligné les difficultés liées aux algorithmes de reconnaissance faciale. (Télécharger la présentation | Regarder la vidéo) Les biais de sélection seront quasiment systématiques dans les données utilisées pour l’apprentissage, comme les photos de visages, ce qui peut conduire à des différences de performance importantes entre différents groupes de la population. Le niveau de performance est représenté par le ratio entre faux positifs et faux négatifs. Ce ratio figurant sur une courbe dite « ROC ». Dans l’idéal, la courbe ROC devrait être identique quel que soit le groupe de la population, mais en réalité cette courbe peut être très différente selon la couleur de peau ou le genre. Mais la non-représentativité des données d’apprentissage n’est pas la seule cause des différences de performance pour les algorithmes de reconnaissance faciale. En effet, même en présence d’un échantillon d’images représentatif, l’algorithme peut avoir du mal à reconnaître certains types de visage (les visages de bébés par exemple). Et la correction de ces biais a presque toujours un impact sur le pouvoir prédictif de l’algorithme, nécessitant des solutions de compromis afin de ne pas détruire complètement la performance.

Enfin, Célia Zolynski, professeure des universités, École de droit, à l’Université de Paris 1 Panthéon Sorbonne, a conclu cette table ronde « académique » en apportant un point de vue juridique sur les biais. (Regarder la vidéo) Elle a rappelé que l’article 1 de la Constitution française assure l’égalité devant la loi de tous les citoyens sans distinction d’origine, de race ou de religion. Ce qui signifie le même traitement pour tous. Un traitement différencié doit être justifié par une situation différente. Le principe d’égalité et de non-discrimination figure également à l’Article 14 de la Convention européenne des droits de l’homme et à l’Article 21 de la Charte des droits fondamentaux de l’UE. Le principe est ensuite développé dans de nombreux textes nationaux, tel que le Code du Travail et le Code Pénal. En droit, on distingue la discrimination directe, un traitement manifestement différencié en fonction du genre ou d’un autre attribut protégé par la loi, et la discrimination indirecte, un traitement en apparence neutre mais qui conduit en réalité à une différence préjudiciable pour un certain groupe de la population. Les sources de discrimination peuvent être endogènes (par exemple : un biais de sélection) ou exogènes, à savoir résulter du contexte ou de l’usage de l’algorithme (le biais de l’automatisation par exemple). Pour identifier et remédier aux biais, les études d’impact sont préconisées à la fois par les autorités européennes (recommandation du 8 avril 2020 du Conseil de l’Europe) et par les autorités canadiennes (Algorithmic Impact Assessment).

Table ronde 2 : Le secteur financier face aux biais algorithmiques

La deuxième table ronde de ce webinaire, animée par Laurent Dupont, data scientist senior à l’ACPR, a regroupé différents acteurs du secteur financier.

Florence Picard, membre du Haut Conseil de l’Institut des actuaires, était la première à présenter l’approche de l’équité dans son métier. (Regarder la vidéo) Elle a évoqué le problème de la différenciation tarifaire en assurances. Les outils prédictifs peuvent conduire à une individualisation du risque et des tarifs d’assurance, mais cela vient au détriment de la mutualisation du risque inhérente au métier de l’assurance. Il faut trouver un équilibre, un optimum d’équité. La solidarité conduit automatiquement à l’inéquité pour certains groupes. Par exemple, les jeunes en bonne santé vont payer plus cher en assurance santé que ce que justifie un calcul de leurs risques, mais cela permet aux anciens, dont la santé est plus fragile, de payer un tarif abordable. Mais quid des comportements dits non-responsables ? Par exemple, des personnes qui fument. Quelles sont les limites de la solidarité ? L’équilibre tarifaire relève de la responsabilité de chaque assureur, avec certaines limites imposées par la loi, comme par exemple l’interdiction d’une différenciation tarifaire en fonction du genre.

Vivien Tran-Thien, Director of AI Consulting au sein de Dataiku, a ensuite donné la vision d’une entreprise du numérique. (Regarder la vidéo) D’abord, il a constaté que beaucoup d’entreprises étaient focalisées sur le RGPD et commencent seulement maintenant à prendre conscience des risques liés aux biais algorithmiques. La première réaction des entreprises est souvent d’éliminer les données dites sensibles, ce qui est cohérent avec l’approche RGPD. Hélas, cela ne suffit pas. Les biais ayant tendance à réapparaître sous une autre forme. Un autre sujet souvent méconnu concerne l’interaction homme/machine et les biais d’automatisation. Comment préserver la qualité de l’intervention humaine face à une suggestion algorithmique ? Un élément important est de faire en sorte que l’algorithme affiche son degré de confiance dans la prédiction. La présentation des variables les plus importantes dans la recommandation est également utile. Enfin, la traçabilité de chaque recommandation est primordiale afin d’analyser les erreurs.

Par la suite, Gaëtan Goldberg, chargé de mission Numérique, Droits et Libertés au sein du Défenseur des droits, a pris la parole en soulignant l’importance de la transparence pour lutter contre les discriminations algorithmiques. (Regarder la vidéo) Il faut en effet que les personnes ciblées par une décision algorithmiques aient conscience qu’elles font l’objet d’un tel traitement afin d’être en mesure de se plaindre d’une éventuelle discrimination. Cette transparence est déjà prévue pour les algorithmes déployés par l’État, mais ne s’impose pas avec autant de force aux algorithmes déployés par le secteur privé. Dans le secteur financier, le Défenseur des droits a eu l’occasion de se prononcer sur un refus de crédit à la consommation en raison de l’âge de l’emprunteur : « si le critère de l’âge peut être une donnée pertinente pour le calcul du risque financier, son utilisation dans les règles métier ne saurait être considérée comme adéquate et proportionnée à la finalité du traitement automatisé lorsqu’elle conduit, non plus à calculer un risque, mais à exclure systématiquement de la procédure d’octroi des crédits les clients âgés de plus de 75 ans ».

Le rapport du Défenseur des droits et de la CNIL sur les algorithmes et les discriminations fournit une série de recommandations, dont la poursuite de recherches sur l’identification et sur les mécanismes de correction des biais. Comme l’a souligné la professeure Zolynski, les études d’impact permettent de prendre en considération les risques de discrimination avant la phase d’exploitation.

Enfin, My Chi To, Executive Deputy Superintendent of Insurance au sein du New York State Department of Financial Services, a conclu cette table ronde en y apportant un regard transatlantique. (Regarder la vidéo) Elle a expliqué que le droit de l’État de New York interdit d’une part l’utilisation par les assureurs de critères protégés tels que l’origine ethnique, et d’autre part toute tarification qui serait indûment discriminatoire (unfairly discriminatory). Le NYDFS a expliqué sa politique en matière d’utilisation d’algorithmes dans l’assurance dans sa lettre circulaire n° 1 du 28 janvier 2019. Cette lettre impose aux assureurs de vérifier que les données utilisées par les algorithmes ne conduisent pas à des tarifs indûment discriminatoires, et que ces données ne contiennent pas des critères protégés. Par ailleurs, la loi impose aux assureurs de donner des raisons d’une décision de refus d’assurer un risque. Il faut qu’il existe un lien logique ou intuitif entre le critère utilisé pour la tarification et le risque. Par exemple, le NYDFS interdit l’utilisation du niveau d’éducation comme critère dans l’assurance automobile, sauf si l’assureur peut démontrer la relation logique entre ce critère et le risque (ce qu’aucun assureur n’a essayé de faire pour l’instant). De nombreux groupes de protection des consommateurs souhaiteraient interdire l’utilisation des scores de crédit (credit scoring) comme critère dans la tarification. Le NYDFS étudie actuellement la question.

Visionner le replay du webinaire

_____________________________________________________________________

Par Winston Maxwell, Télécom Paris – Institut Polytechnique de Paris

_____________________________________________________________________

Illustration : freepik – fr.freepik.com