Quand la data science se met au service de la performance industrielle

vendredi 17 juin 2022

Image d’entête source Jcomp/Freepik

Le projet Start2 fait partie de ces opportunités de mutualisation des expériences où la data science a permis de diviser par deux le taux de défectuosité des pièces aux tests finaux. Pavlo Mozharovskyi, maître de conférences à Télécom Paris et chercheur au sein de DSAIDIS, et Éric Manouvrier, data analyst et Master expert en LEAN 6 sigma chez Valeo, reviennent sur cette collaboration réussie.

Quelle a été l’origine de votre collaboration sur ce projet ?

Pavlo Mozharovskyi : Florence D’Alché-Buc, porteuse de la chaire DSAIDIS et moi-même avions travaillé avec une autre équipe de Valeo sur un projet appelé Expresso. Malheureusement le jeu de données issu de cette ligne de production n’a pas permis d’exploiter autant que souhaité nos travaux sur la détection d’anomalies et le projet a été fermé en décembre 2020.

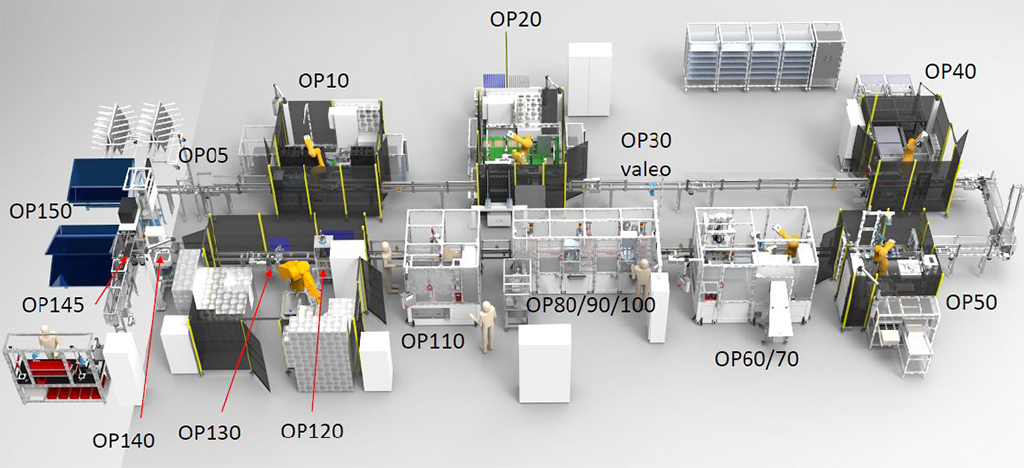

Éric Manouvrier : À la suite de cela, la direction de Valeo m’a demandé de fournir un jeu de données issu d’une autre ligne de production, Start2. C’est ainsi qu’a démarré en 2021 un nouveau travail de collaboration avec Florence et Pavlo, dans la lignée de ce qui avait été initié avec Expresso.

Qu’est-ce qui a évolué entre ces deux projets, Expresso et Start2 ?

PM: Pour nous, ce projet s’inscrit vraiment dans la continuité du précédent. Nous avons tout de même agrandi l’équipe et recruté un ingénieur, Arturo Castellanos Salinas, pour travailler spécifiquement sur Start2. Mais le changement vient surtout de la ligne de production d’où proviennent les données, et de la collaboration avec une nouvelle équipe chez Valeo, menée par Éric.

EM: De notre côté, une des innovations majeures a été la découverte d’un environnement de traçabilité de la qualité pour y faire de la performance. Avant, nous ne nous intéressions aux données qu’en cas de problème qualité, en regardant a posteriori les caractéristiques d’une pièce défectueuse. Or sur ces projets, nous explorons les données pour optimiser le réglage des stations de travail et réduire les mauvaises pièces en sortie de ligne. Le projet Expresso nous a fait prendre conscience de la nécessité d’avoir un jeu de données de qualité, ce qui est difficile à obtenir pour de nombreuses raisons. Sur Start2, nous avons donc passé du temps à structurer un jeu de données beaucoup plus riche pour alimenter les algorithmes développés par Télécom Paris.

Quels outils ont été mis en place pour analyser ces données ?

PM: Nous avons développé une méthodologie statistique en plusieurs parties dont la première est la visualisation. C’est une étape très importante car la visualisation permet de comprendre les données, elle représente quasiment la moitié du travail.

Pour cela, nous avons déployé différents outils. Le premier est la représentation temporelle des paramètres de production. Nous avons à la fois regardé l’évolution d’un même paramètre au cours du temps, en suivant l’apparition d’anomalies en fonction de la valeur de ce paramètre, et à la fois comparé plusieurs paramètres sur une même échelle de temps pour comprendre leur dépendance statistique.

Le deuxième outil est la représentation du flux physique des pièces sous forme de diagramme « spaghetti », où chaque « spaghetti » correspond au parcours d’une pièce dans la ligne de production. Ce type de diagramme permet de constater si les lignes fonctionnent correctement ou s’il y a des retards à certains niveaux. Les retards sont visualisés par des trous dans les lignes de passage des pièces. Nous cherchions donc à obtenir un diagramme bien rempli, signifiant qu’il n’y a pas de perte de temps et donc pas de perte d’argent.

EM : Nous pensions que la solution viendrait des algorithmes de machine learning mais c’est finalement la visualisation qui a été clé dans la réussite de ce projet.

PM : Nous avons aussi déployé des méthodes statistiques pour observer le fonctionnement de la ligne, et notamment, sur les derniers mois du projet, nous avons utilisé une méthode de binning afin de visualiser à l’aide de régressions et de tests statistiques la dépendance entre les paramètres.

Quelles conclusions avez-vous tirées de l’utilisation de ces différents outils et quelles actions avez-vous mises en place ?

EM : Grâce à la visualisation des paramètres de production, nous avons identifié ceux qui étaient décisifs pour éviter les défauts sur le banc de test. Cela a été confirmé par le binning, ce qui nous a conforté dans notre décision d’essayer un nouveau réglage. Lorsque nous l’avons fait, le taux de défauts a été immédiatement divisé par deux ! Cela faisait quatre ans que nous n’avions pas observé une telle rupture dans le taux de rejet. Nos équipes de production ont été « bluffées » de voir que des personnes extérieures étaient capables d’identifier les sources d’anomalies et de suggérer un changement de réglage qui fonctionne.

Qu’est-ce qui a fait le succès de ce projet, et de votre collaboration en particulier ?

EM : Quasiment toutes les semaines, nous faisions le point sur ce qui était en cours, à faire, sur les conclusions tirées des graphiques… Cette « ritualisation » de notre méthode de travail a favorisé les échanges et facilité la résolution d’une multitude de petits problèmes, notamment au niveau de l’extraction des données.

PM : Nous avons beaucoup appris des deux côtés. Nous sommes avant tout des académiques, pas des industriels, donc nous avons aussi tâtonné pour aider à améliorer la qualité de ces données issues de lignes de production. Nous avons donné des consignes au fur et à mesure et l’équipe Valeo a été très réactive, ce qui nous a permis de poursuivre nos travaux de façon efficace.

EM : Globalement, ce qui a fonctionné sur ce projet, c’est le travail en équipe avec des gens qualifiés. Du côté de Valeo, l’équipe mise en place associait à la fois des experts métiers, un responsable et un superviseur de production pour donner du sens à la donnée, et des data scientists dont je fais partie, c’est-à-dire des profils polyvalents qui comprennent les données et le terrain. L’ensemble du dispositif a été sponsorisé par un directeur industriel, Romain Bruniaux, qui a participé en personne à certaines réunions techniques. L’implication de la direction dans ce type de projet novateur est indispensable. Il a fallu la conviction de la direction des deux partenaires – Florence d’Alché-Buc chez Télécom Paris et Romain Bruniaux chez Valeo – pour doter le projet en ressources humaines, techniques, financières… En retour, le succès qui remonte du terrain est un facteur clé pour la scalability, c’est-à-dire le passage à l’échelle.

Quelles sont les suites envisagées pour ce projet ?

EM : Après le changement de réglage, nous avons continué un peu les développements, mais sans trouver plus d’optimisations. Nous avons fermé le projet Start2 et avons tout de suite poursuivi avec un nouveau cas d’usage actuellement en cours pour accompagner le lancement d’un nouveau produit, toujours sur le site de Saint-Quentin Fallavier (Isère). Avec ce projet, nous passons à l’échelle supérieure puisque quatre lignes de production sont concernées. Nous avons également renforcé notre collaboration par le recrutement conjoint d’un doctorant dédié à ce sujet. Nous avons co-écrit le sujet de thèse avec les équipes de Télécom Paris et sélectionné ensemble le candidat, pour son profil à l’interface de la recherche et de l’industrie.

On peut donc imaginer de nombreux autres projets entre Valeo et Télécom Paris pour l’avenir ?

EM : Aujourd’hui le moteur de notre collaboration avec Télécom Paris, ce sont les résultats. Le fait d’avoir des bons résultats sur des cas d’usage – résoudre des problèmes qualité, produire plus de pièces, supprimer les aléas quotidiens en production, etc. – crédibilise la démarche d’une collaboration de recherche en data science avec une école. Plus on améliore la production et plus on va ouvrir des chantiers de data science qui vont eux-mêmes générer des résultats. Tout cela forme un cercle vertueux.