Qu'est-ce que la théorie de l'information ? (CultureMath)

lundi 5 juillet 2021

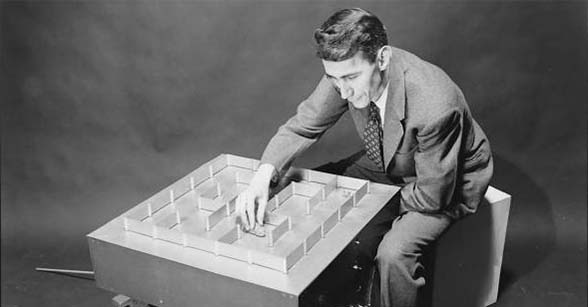

Shannon et sa souris Theseus en 1950. Source CultureMath. Licence CC-BY-SA

On doit la réponse à cette question à Claude Shannon, mathématicien et ingénieur américain considéré comme le « père de l’âge de l’information ».

Son nom ne vous dit peut-être pas grand chose. Hollywood a glorifié d’autres héros scientifiques comme Alan Turing ou John Nash. Shannon, lui, a eu une vie rangée, modeste… et surtout ludique : adepte du monocycle et du jonglage, il s’est amusé à construire des machines plus ou moins loufoques : une souris qui apprend et retrouve son chemin dans un labyrinthe, une machine à jouer aux échecs, une autre à résoudre le Rubik’s cube, une calculatrice en chiffres romains, un robot qui jongle avec trois balles, un bâton sauteur motorisé, et même une « machine inutile », qui dès qu’on l’allume, actionne une main pour s’éteindre elle-même… Dans le même temps, il a fait des avancées théoriques décisives dans des domaines aussi divers que les circuits logiques, la cryptographie, l’intelligence artificielle, l’investissement boursier et le wearable computing.

Mais surtout, Shannon crée la théorie de l’information en 1948, dans un seul article — A Mathematical Theory of Communication — le résultat de plusieurs années de recherche. Cette théorie révolutionnaire rassemble tellement d’avancées fondamentales et de coups de génie que Shannon est aujourd’hui le héros de milliers de chercheurs. On peut dire, sans exagérer, que c’est le mathématicien dont les théorèmes ont rendu possible le monde du numérique que nous connaissons aujourd’hui.

Décrivons plus en détail ses contributions les plus marquantes.